Американская компания Apple объявила о трех новых методах по обеспечению защиты детей в iPhone, iPad и Mac. Это включает в себя новые функции безопасности общения в сообщениях, улучшенное обнаружение материалов о сексуальном насилии над детьми (CSAM) в iCloud и обновленную информацию для Siri и поиска.

Apple подчеркивает, что ее новая программа амбициозна, но «защита детей — важная обязанность». Имея это в виду, Apple заявляет, что ее усилия будут «со временем развиваться и расширяться».

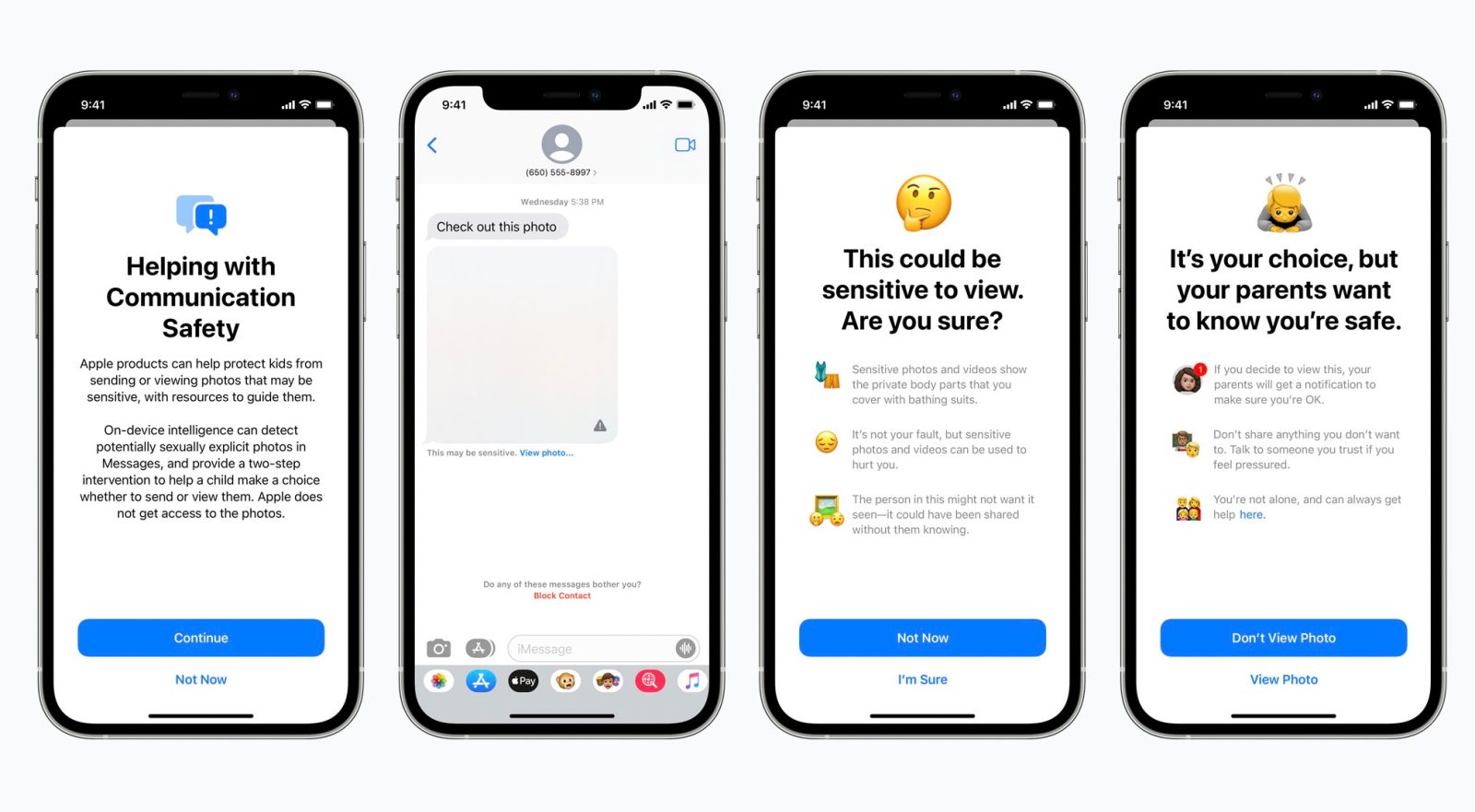

К слову, объявление в смс — это новая функция безопасности общения в приложении «Сообщения». Как поясняет Apple, когда ребенок из iCloud получает или пытается отправить фотографии откровенно сексуального характера, ребенок увидит предупреждающее сообщение, а изображение будет размытым.

Также, Apple объявляет о новых мерах по борьбе с распространением материалов о сексуальном насилии над детьми (CSAM). Apple объясняет, что CSAM относится к контенту, изображающему откровенно сексуальные действия с участием ребенка. После, как Apple обнаружит изображения CSAM, если они хранятся в iCloud Photos, Apple может сообщать об этом в Национальный центр пропавших без вести и эксплуатируемых детей, организацию, которая действует как комплексное агентство по отчетности для CSAM и тесно сотрудничает с правоохранительными органами.

Apple также расширяет возможности Siri и Поиска, предоставляя дополнительные ресурсы, чтобы помочь детям и родителям оставаться в безопасности в Интернете и получать помощь в небезопасных ситуациях. Например, пользователям, которые спрашивают Siri, как они могут сообщить о CSAM или эксплуатации детей, будут указаны ресурсы, где и как отправить отчет.